AIエージェントは、人工知能の進化と共に私たちの日常生活やビジネスの様々な側面で重要な役割を果たしてきました。このテクノロジーは、シンプルな自動応答システムから、複雑な意思決定をサポートする高度なアシスタントに至るまで、幅広い形で実現されています。AIエージェントの目的は、人間の作業を補助し、効率化することにありますが、その実現方法と応用範囲は非常に多岐にわたります。

本記事では、AIエージェントの基礎から最先端の応用例までを網羅的に紹介し、これらのシステムがどのようにして私たちの世界を変えているのか、そして将来どのような可能性を秘めているのかを探求します。AI技術の急速な進化によって、これまでにないほどの可能性が開かれつつある今、AIエージェントがもたらす変革について知ることは、あらゆる業界の専門家だけでなく、一般の人々にとっても重要です。この記事を通じて、AIエージェントの驚異の世界への理解を深め、その将来性について一緒に考えてみましょう。

AIエージェントの歴史と進化

AIエージェントの歴史は、20世紀半ばにさかのぼります。初期の段階では、人工知能研究は主に理論的な探求に限定されていましたが、時間が経つにつれて、具体的な応用への道が開かれていきました。以下のタイムラインでは、AIエージェントの歴史におけるいくつかの重要なマイルストーンを示しています。

- 1960年代: ELIZAの開発により、初めてコンピュータが人間の言語を模倣することが可能になりました。ELIZAはシンプルなパターンマッチングに基づいており、人間との対話が可能な最初のプログラムの一つとされています。

- 1997年: チェスプレイヤーのガリー・カスパロフを破ったIBMのDeep Blueは、特定のタスクにおける人間の知能を超えることができるコンピュータの可能性を世界に示しました。

- 2011年: Siriの登場により、スマートフォンユーザーは音声コマンドを通じて情報を検索したり、日常のタスクを管理することが可能になりました。これは、一般消費者向けのAIアシスタントの普及の始まりを意味しています。

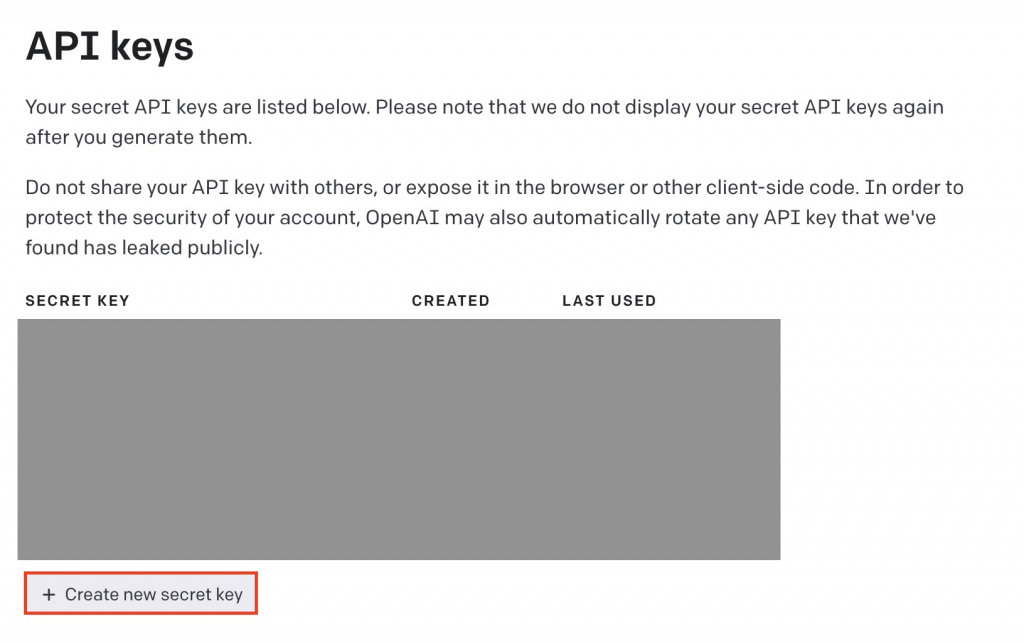

- 最近: OpenAIのChatGPTのような高度な自然言語処理技術を利用したAIエージェントは、人間との対話において前例のないレベルの能力を示しています。これらの技術は、教育、カスタマーサポート、エンターテインメントなど、様々な分野で応用されています。

このように、AIエージェントは数十年にわたる研究と開発の成果に支えられ、今日では私たちの生活に不可欠な存在となっています。次に、AIエージェントの主要な種類とそれぞれの特徴について詳しく見ていきましょう。

主要なAIエージェントの種類

AIエージェントは、その機能や用途によって様々な種類に分類されます。ここでは、特に重要とされるいくつかの主要なカテゴリーについて紹介します。

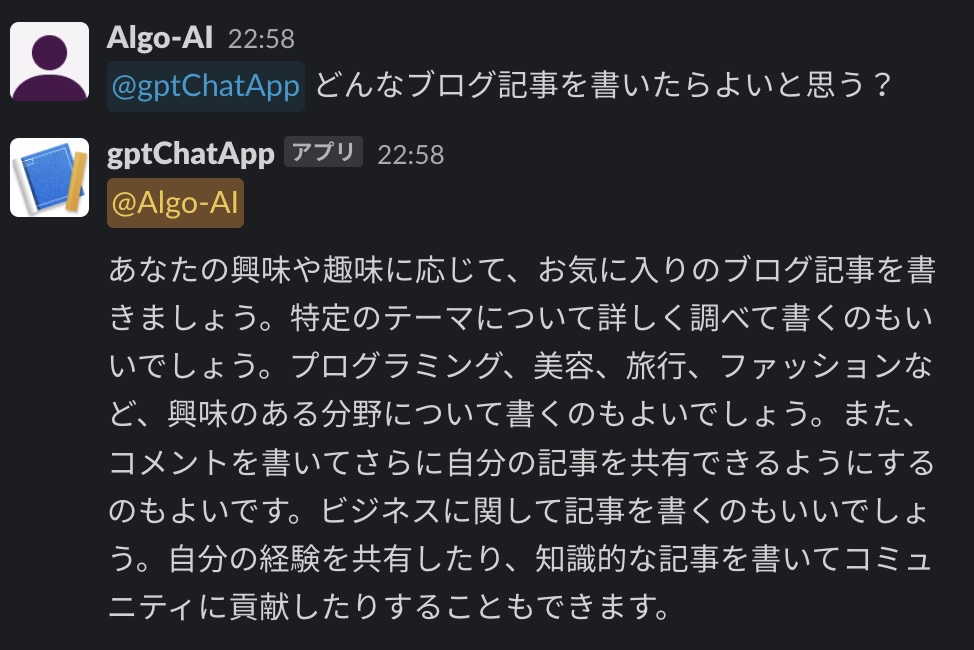

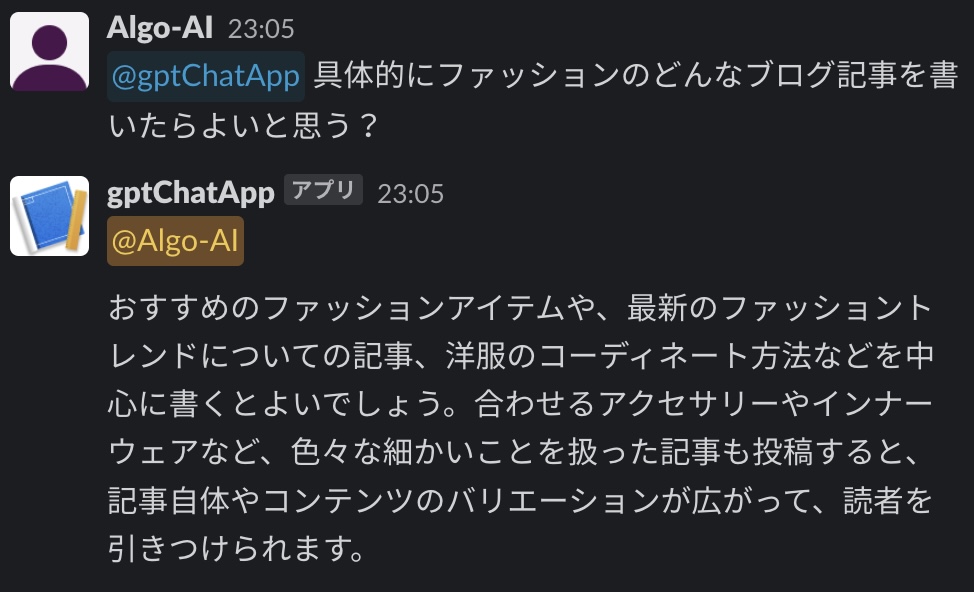

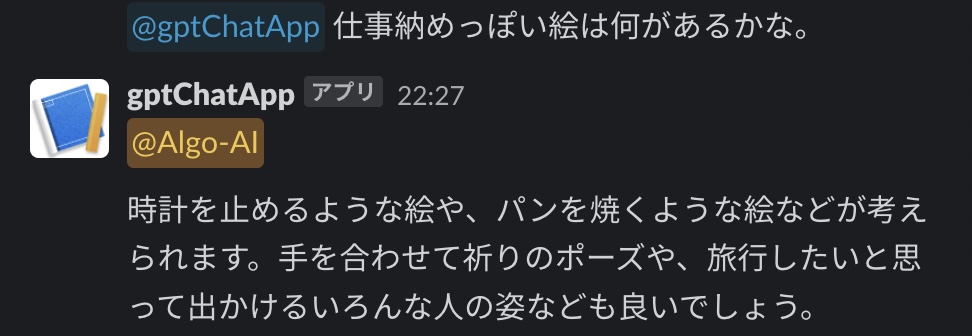

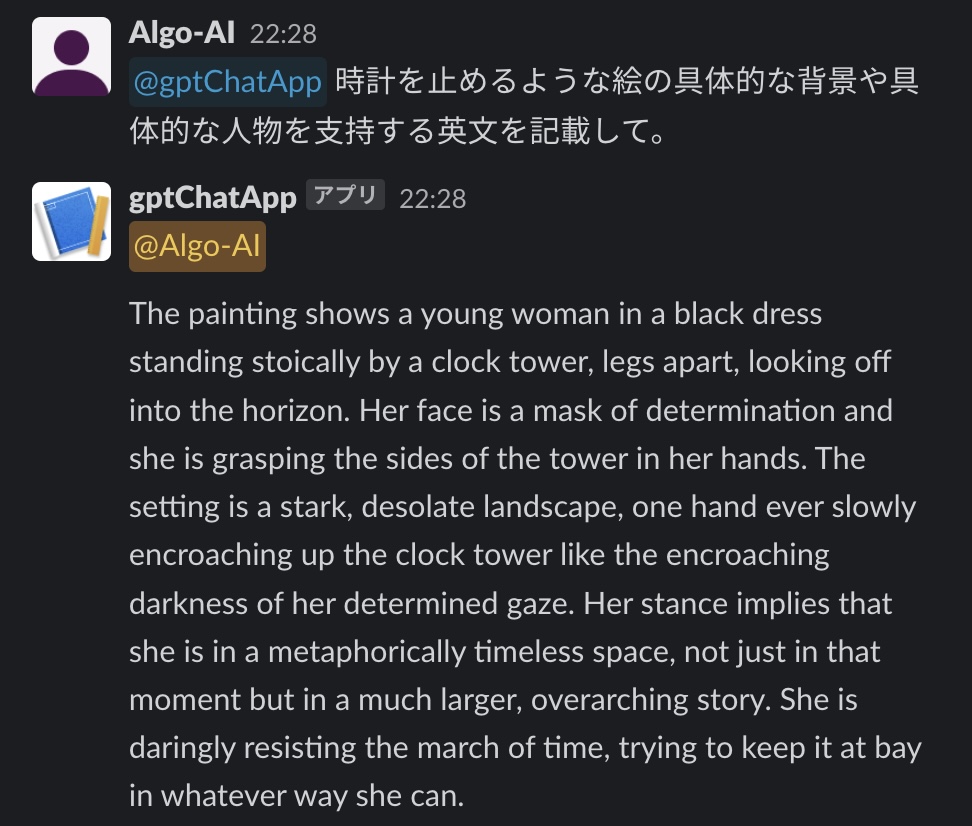

1. チャットボット

チャットボットは、テキストまたは音声による対話を通じて、人間のユーザーとコミュニケーションを取るAIエージェントです。顧客サービス、オンラインショッピングアシスタント、健康相談など、幅広い応用があります。自然言語処理(NLP)技術を活用して人間の言語を理解し、適切な回答を生成します。

2. 仮想アシスタント

SiriやGoogle Assistantのような仮想アシスタントは、音声認識と自然言語理解を組み合わせたAIエージェントの一種です。これらは、ユーザーの質問に答えたり、カレンダーの管理、アラームの設定、天気予報の提供など、様々なタスクを実行できます。仮想アシスタントは、スマートフォンやスマートスピーカーなどのデバイスを通じて日常生活に密接に組み込まれています。

3. 自律型エージェント

自律型エージェントは、環境の監視とそこでの自律的な意思決定を行うAIシステムです。これには、自動運転車、ドローン、ロボティックスなどが含まれます。これらのエージェントは、センサーからのデータを解析し、環境内でのナビゲーションやタスクの実行を可能にする複雑なアルゴリズムを利用しています。

4. 推薦エンジン

NetflixやAmazonの推薦システムのように、ユーザーの過去の行動や好みに基づいて、関連する商品やコンテンツを提案するAIエージェントです。これらのシステムは、大量のデータを分析し、個々のユーザーにパーソナライズされた体験を提供することで、エンゲージメントの向上や売上の増加に貢献しています。

これらのAIエージェントは、様々な技術的基盤を用いて構築されており、それぞれが特定のニーズに応じたユニークな機能と応用範囲を持っています。次に、これらのエージェントを支える主要な技術について詳しく見ていきましょう。

AIエージェントの技術基盤

AIエージェントの能力は、その背後にある複数の技術によって支えられています。これらの技術は、AIエージェントが複雑なタスクを処理し、人間のように学習し、適応することを可能にします。主要な技術基盤には、以下のようなものがあります。

機械学習

機械学習は、AIエージェントにとって最も重要な技術の一つです。これは、データから学習し、その学習を基に新しい入力に対して予測や判断を行うアルゴリズムの集合体です。機械学習モデルは、大量のデータを処理し、その中からパターンを識別して学習します。この技術は、推薦システム、画像認識、自然言語処理など、多くのAIアプリケーションにおいて中心的な役割を果たしています。

自然言語処理(NLP)

自然言語処理は、コンピュータが人間の言語を理解し、生成する能力を開発するための技術分野です。NLPは、テキストデータの分析、意味の抽出、さらには言語生成に至るまで、幅広い応用があります。チャットボットや仮想アシスタントなど、自然言語を介してユーザーと対話するAIエージェントにとって、NLPは不可欠です。

深層学習

深層学習は、機械学習の一部門であり、特に大量のデータから複雑な表現を学習するために設計されたアルゴリズムです。深層学習モデルは、多層のニューラルネットワークを使用して、画像、音声、テキストなどのデータから高レベルの抽象化を行います。この技術は、画像認識、音声認識、自然言語理解の分野で革命的な進歩をもたらしました。

強化学習

強化学習は、特定の目標を達成するために最適な行動を学習するAIエージェントの訓練方法です。エージェントは、環境からのフィードバック(報酬やペナルティ)に基づいて行動を選択し、最終的に目標達成につながる最適な行動パターンを見つけ出します。自律型エージェントやゲームプレイの最適化など、さまざまな領域で応用されています。

これらの技術基盤は、AIエージェントの知能を形成する上で不可欠な要素であり、それぞれがAIエージェントの異なる能力を引き出します。次に、これらの技術が現実世界でどのように応用されているのか、いくつかの具体例を通じて見ていきましょう。

AIエージェントの現在の応用例

AIエージェントは現代社会のさまざまな側面で応用されており、人々の生活を豊かにし、ビジネスの効率化を促進しています。以下は、AIエージェントが特に影響を与えている分野のいくつかです。

顧客サービス

多くの企業では、顧客からの問い合わせに対応するためにチャットボットが導入されています。これらのAIエージェントは、顧客の質問に即座に回答することができ、24時間体制でサービスを提供します。また、より複雑な問題については、適切な人間のオペレーターにエスカレーションすることも可能です。これにより、顧客満足度の向上とオペレーションコストの削減が実現されています。

ヘルスケア

AIエージェントは、医療分野でも重要な役割を果たしています。例えば、患者の症状から最も可能性の高い疾患を診断したり、医師の診断をサポートするためのデータ分析を行ったりします。また、患者の健康管理や治療計画の策定に役立つ情報を提供するアプリケーションも登場しています。

金融サービス

金融業界では、AIエージェントが投資の決定支援やリスク管理、顧客サービスの向上などに利用されています。ロボアドバイザーは、ユーザーの投資目標やリスク許容度に基づいて、最適なポートフォリオを提案します。また、フロード検出システムは、不正な取引をリアルタイムで特定し、金融犯罪の防止に貢献しています。

エンターテインメント

映画や音楽、ゲームなどのエンターテインメント分野でも、AIエージェントがクリエイティブなプロセスを支援しています。映画の編集から音楽の作曲、ゲーム内の非プレイヤーキャラクター(NPC)の行動パターンの生成まで、AIは創造的な活動を新たなレベルに引き上げています。また、個々のユーザーの好みに合わせてコンテンツを推薦するシステムも、AI技術によって可能になっています。

これらの例は、AIエージェントが私たちの生活や仕事にどのように統合され、有用なツールとして機能しているかを示しています。しかし、これらの進歩には、プライバシーの保護、倫理的な判断、技術の透明性など、解決すべき課題も伴います。次に、AIエージェントの未来と直面している課題について考察します。

AIエージェントの未来と課題

AIエージェントの技術は日々進化を遂げており、その応用範囲も広がり続けています。しかし、これらの技術の発展は、倫理的、社会的な課題を引き起こす可能性もあります。以下に、AIエージェントの未来に対する展望と共に、直面している課題について述べます。

未来の展望

- より高度な自律性: AIエージェントは、学習と適応の能力を高め、より複雑な環境での自律的な判断が可能になるでしょう。これにより、自動運転車からスマートシティの管理まで、さまざまな領域での応用が期待されます。

- 人間との協働: AIエージェントは、人間の能力を補完し、協働することで新たな価値を生み出します。例えば、創造的なプロセスや意思決定プロセスにおいて、AIの提供するデータ駆動型の洞察が人間の直感や経験と組み合わさることで、より良い成果をもたらすことが期待されます。

- パーソナライズと個別化: AIエージェントは、個々のユーザーのニーズや好みに合わせてサービスを提供することがますます可能になります。教育やヘルスケアなどの分野で、個人に合わせたカスタマイズされた体験が実現されるでしょう。

直面している課題

- プライバシーとセキュリティ: AIエージェントが個人のデータを収集・分析することは、プライバシー侵害の懸念を引き起こします。また、セキュリティの脆弱性が悪用されるリスクもあります。

- 倫理的な判断: AIエージェントが倫理的な判断を下すことは困難であり、その行動が人間の倫理観と一致する保証はありません。AIの意思決定プロセスにおける透明性と倫理的なガイドラインの確立が求められます。

- 雇用への影響: AIエージェントによる自動化の進展は、特定の職種における雇用の減少を招く可能性があります。新たな技術の導入と社会経済システムとの調和が必要です。

- バイアスと公平性: AIエージェントは、訓練に使用されるデータに含まれるバイアスを学習することがあります。これにより、不公平や差別が再生産されるリスクがあります。

結論

AIエージェントは、私たちの生活や社会に多大な影響を与える技術であり、その可能性は計り知れません。未来に向けては、技術的な進歩と共に、倫理的、社会的な課題への対応が不可欠です。AIエージェントの発展を通じて、より良い未来を築くためには、多様なステークホルダーが協力し、包括的なアプローチを取ることが重要です。技術の力を倫理的に利用し、すべての人々にとっての利益を最大化することが、私たちの共通の目標であるべきです。

AIエージェントに関するこの探究は、技術の現在と未来の可能性、そしてそれが私たちの世界とどのように関わっていくかについての一瞥を提供しました。引き続き、この興味深い分野の発展に注目していくことをお勧めします。

読者へのアクション呼びかけ

AIエージェントの進化は、私たちの生活に新たな便利さをもたらし、ビジネスの運営方法を根本から変える可能性を秘めています。しかし、その一方で、プライバシー、セキュリティ、倫理的な問題など、多くの課題にも直面しています。技術の進歩を正しく理解し、それを利用する上での責任について考えることが、これからの社会に求められる重要な姿勢です。

- 学びを深める: AIとその応用についてさらに学び、技術の基礎理解を深めましょう。オンラインコースやセミナーに参加し、最新の研究やトレンドについて学ぶことが重要です。

- 倫理的な考察: AI技術の利用にあたっては、その倫理的な側面についても考慮し、公正で透明性のある利用を心がけましょう。

- 積極的な参加: AI技術の開発や政策形成に関する議論に参加し、多様な声が反映されるように努めましょう。社会全体で技術の利用に関する合意形成を図ることが、健全な発展には不可欠です。

学習リソースへの案内

AIに関するさらなる理解を深めたい場合は、以下のリソースが役立つでしょう。

- オンラインコース: CourseraやedXなどのプラットフォームでは、AIや機械学習に関する多くのコースが提供されています。初心者から上級者まで、幅広いレベルの内容がカバーされています。

- 書籍: 「人工知能は人間を超えるか」や「ディープラーニング」など、AIに関する基礎から応用までを解説した書籍が多数出版されています。

- セミナー・ワークショップ: 大学や研究機関、業界団体が主催するセミナーやワークショップに参加し、最先端の知識や技術トレンドを学ぶことができます。

AI技術は、私たちの未来を形作る重要な要素です。この技術を理解し、適切に活用することで、より良い社会の実現に貢献できるでしょう。引き続き、AIとその可能性について探求し、学び続けることが重要です。

]]>